Figure AI在周四终于揭示了导致这家备受关注的机器人初创公司与其投资者OpenAI断绝关系的“重大突破”:一种新颖的双系统AI架构,使机器人能够理解自然语言命令并操控它们从未见过的物体——而无需对每个物体进行特定的预训练或编程。

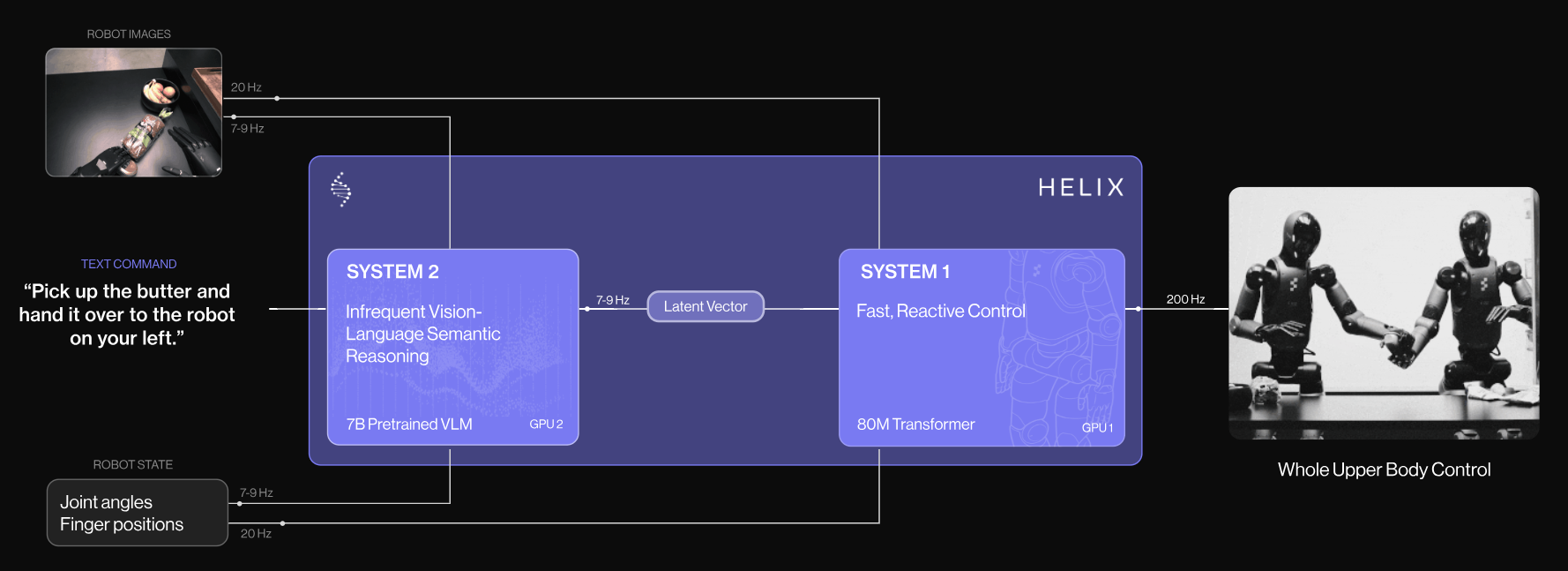

与传统机器人需要为每个新任务进行广泛编程或演示不同,Helix将高级推理系统与实时运动控制相结合。其两个系统有效地弥合了语义理解(知道物体是什么)与动作或运动控制(知道如何操控这些物体)之间的差距。

这将使机器人能够随着时间的推移变得更强大,而无需更新其系统或在新数据上进行训练。为了演示其工作原理,该公司发布了一段视频,展示了两个Figure机器人协同工作,将杂货放好,一个机器人将物品递给另一个,后者将其放入抽屉和冰箱中。

Figure声称,两个机器人都不知道它们正在处理的物品,但它们能够识别哪些物品应该放入冰箱,哪些物品应该干存储。

“Helix可以推广到任何家庭物品,”Adcock在推特上写道。“像人类一样,Helix理解语言,推理问题,并能够抓取任何物体——这一切都无需训练或代码。”

魔法是如何运作的

为了实现这种泛化能力,这家位于加利福尼亚州桑尼维尔的初创公司还开发了一个称为视觉-语言-动作(VLA)模型,该模型统一了感知、语言理解和学习控制,这使得其模型能够进行泛化。

Figure声称,这个模型在机器人技术上标志着多个首次。它以200Hz的频率输出整个类人上半身的连续控制,包括单个手指的运动、手腕位置、躯干方向和头部方向。它还允许两个机器人在处理它们从未见过的物体时协作完成任务。

Helix的突破来自其双系统架构,反映了人类认知:一个70亿参数的“系统2”视觉-语言模型(VLM),以7-9Hz的频率处理高级理解(每秒更新9次,慢速思考以应对结构性和复杂任务或运动),以及一个8000万参数的“系统1”视觉运动策略,将这些指令转化为200Hz的精确物理动作(基本上每秒更新200次),以实现快速思考。

图片:Figure AI

与以往的方法不同,Helix对所有行为使用一组神经网络权重,而无需特定任务的微调。一个系统处理语音和视觉数据,以实现复杂的决策,而另一个系统将这些指令转化为精确的运动动作,以实现实时响应。

“我们已经在这个项目上工作了一年多,旨在解决通用机器人问题,”Adcock在推特上写道。“仅靠编码是行不通的;我们只需要在能力上实现一次飞跃,以扩展到十亿单位的机器人水平。”

Helix表示,所有这些为机器人技术开辟了一条新的扩展法则,这条法则不依赖于编码,而是依赖于一种集体努力,使模型在没有任何特定任务的先前训练的情况下变得更强大。

图片:Figure AI

Figure在大约500小时的远程操作机器人行为上训练了Helix,然后使用自动标记过程为每个演示生成自然语言指令。整个系统在机器人的嵌入式GPU上运行,使其立即可以商业化使用。

Figure AI表示,它已经与宝马制造公司和一家未透露名称的美国大型客户达成了协议。Adcock表示,公司相信这些合作伙伴关系为“在未来四年内实现10万台机器人的目标铺平了道路”。

这家类人机器人公司在今年早些时候获得了6.75亿美元的B轮融资,投资者包括OpenAI、微软、NVIDIA和杰夫·贝索斯,估值为26亿美元。据报道,它正在谈判再融资15亿美元,这将使公司的估值达到395亿美元。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。