Lumoz Decentralized AI:https://chat.lumoz.org

引言

在 AI 技术飞速发展的进展,计算资源的高昂成本、数据隐私的安全隐患以及中心化架构的局限性,成为制约AI普及和创新的重要障碍。传统AI计算依赖于大型科技公司所掌控的集中式服务器,导致算力资源被垄断,开发者面临高额成本,同时用户的数据安全也难以得到真正保障。

Lumoz Decentralized AI(LDAI) 正在引领一场 AI计算的去中心化革命。它通过结合 区块链技术、零知识证明(ZK)算法和分布式计算架构,打造了一个 安全、低成本、高效能的AI计算平台,彻底改变了传统AI计算的游戏规则。LDAI 让全球开发者能够公平访问顶级AI模型和计算资源,同时确保数据隐私不受侵犯,为AI行业带来了全新的范式转变。

在本篇文章中,我们将深入探讨 LDAI的核心技术、架构设计以及广泛的应用场景,并剖析它如何推动AI行业迈向更加开放、公平和可信的未来。

1.Lumoz Decentralized AI (LDAI)是什么?

LDAI 是一个基于去中心化架构的AI平台,旨在解决传统集中式AI生态系统中的三大关键问题:单点故障、高昂的计算资源成本、以及数据隐私问题。LDAI结合了区块链技术和零知识证明(ZK)算法,创造出一种全新的可信AI基础设施。

LDAI通过去中心化的节点网络,提供了弹性计算架构。传统AI系统通常依赖于中心化的服务器集群,这种架构容易受到单点故障的影响,导致服务中断。而LDAI通过分布式节点保证了高可用性和可靠性,确保99.99%的持续AI服务可用性。

LDAI打破了计算资源的垄断,提供了全球化、分布式的计算能力。通过Lumoz链,LDAI将来自多个国家的计算资源进行集成,使开发者能够低成本甚至零成本访问顶级AI模型,如Deepseek和LLaMA。这种计算资源的民主化使得AI开发不再受到高昂硬件成本的限制,推动了技术创新的普及。

LDAI解决了数据隐私问题。通过零知识证明加密算法和去中心化存储协议,LDAI确保用户的数据资产得以加密保护,并且用户始终对自己的数据拥有主权。这种三层保护机制不仅保证了数据的安全性,还保障了用户隐私,彻底结束了“数据殖民”的时代。

2. Lumoz Decentralized AI 架构

LDAI的架构设计充分体现了去中心化、模块化和灵活性,确保系统能够在高并发和大规模计算场景下高效运作。以下是LDAI架构的主要组成部分:

2.1 架构层次结构

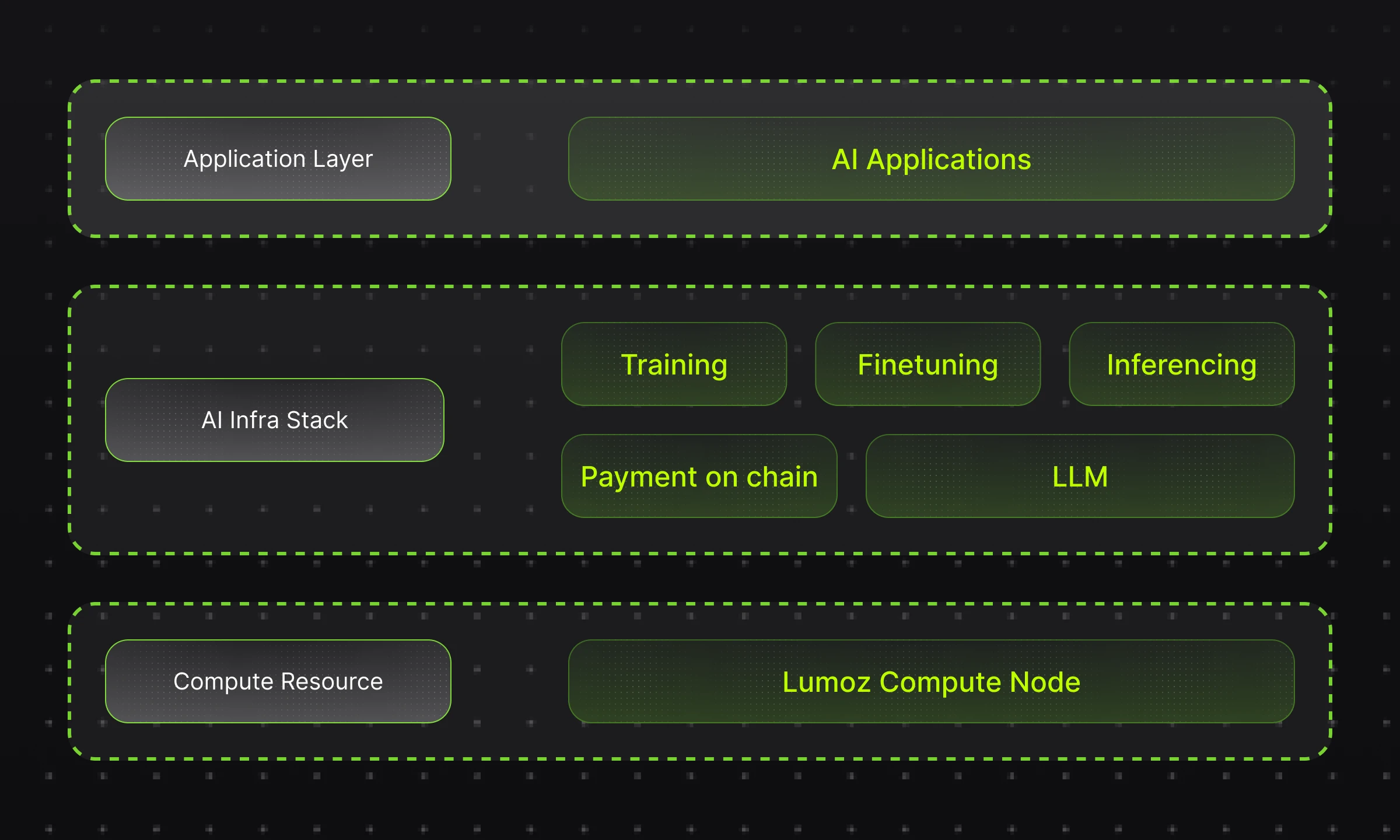

LDAI的架构分为三个主要层次:应用层、AI基础设施层、计算资源层。

应用层:这一层主要负责与AI应用的交互,包括模型训练(Training)、微调(Finetuning)、推理(Inferencing)以及链上支付(Payment on chain)。该层通过提供标准化的API接口,使开发者可以轻松集成LDAI的计算资源,构建各类AI应用。

AI基础设施层:该层包含了训练、微调、推理等基础功能,并且支持AI任务的高效调度。区块链技术在此层发挥了至关重要的作用,保证了AI应用在去中心化环境中的执行稳定性和透明度。

计算资源层:LDAI通过Lumoz Compute Node和计算集群的组合,提供去中心化的计算能力。每个计算节点不仅提供计算服务,还参与资源调度和任务分配。该层的设计确保了AI计算的弹性和扩展性

2.2 架构设计

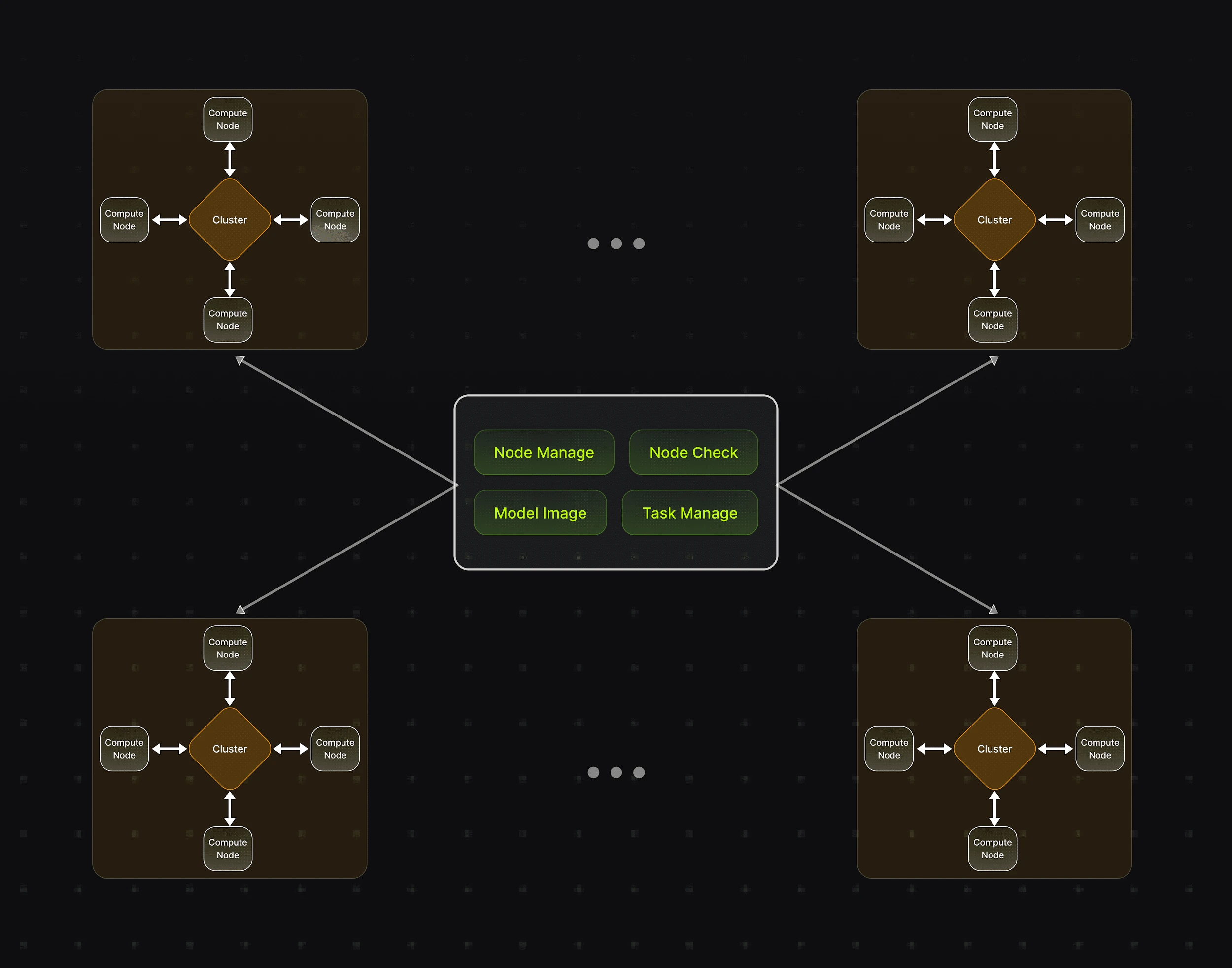

LDAI的计算资源通过去中心化的集群管理机制进行调度。每个计算节点通过Lumoz链协同工作,节点之间通过去中心化协议保持高效的通信与资源共享。这一架构实现了以下几个重要功能:

节点管理:管理节点加入或退出网络,管理用户奖励和处罚

任务调度:AI任务根据节点的负载情况,动态分配至不同的计算节点,从而优化计算资源的利用率。

模型管理:对热点模型进行镜像存储,提高用户加入网络和启动模型计算速度

节点检查:集群中每个节点的健康状态和任务负载能够实时监控,保证系统的高可用性和稳定性。

核心架构与资源调度

LDAI的核心架构基于多个计算集群,每个集群由多个节点组成,这些节点不仅可以是GPU计算设备,还可以是计算节点与存储节点的组合。每个节点独立工作,但又通过LDAI的去中心化调度机制进行协作,共同完成任务计算。集群采用自适应算法,根据负载情况实时调整计算资源,确保每个节点的工作负载保持在最优水平,从而提升整体计算效率。

LDAI使用了一种智能调度系统,该系统能够根据任务的具体需求、计算资源的实时可用性和网络带宽等因素,自动选择最佳的节点进行计算。这种动态调度能力确保了在面对复杂的计算任务时,系统能够灵活应对,而无需手动干预。

高效的容器化部署与动态资源管理

为了进一步提升计算资源的灵活性与利用率,LDAI采用了容器化技术。容器可以在多个计算环境中快速部署和执行,且能够根据任务的需求动态调整所需的资源。通过容器化,LDAI能够将计算任务与底层硬件解耦,避免了传统计算环境中对硬件的强依赖性,提高了系统的可移植性与弹性。

LDAI的容器化平台支持对GPU资源的动态分配与调度。具体而言,容器能够根据任务的实时需求调整GPU资源的使用,从而避免因资源分配不均而导致的计算瓶颈。容器化平台还支持容器之间的负载均衡和资源共享,通过高效的资源调度算法,实现多任务并发处理,同时保证每个任务的计算资源得到合理分配。

弹性计算与自动扩展

LDAI平台还引入了自动扩展机制。系统能够根据计算需求的波动,自动扩展或缩减集群规模。例如,当某些任务需要大量计算时,LDAI能够自动启动更多节点,分担计算负载;反之,在负载较低时,系统则会自动缩减计算集群的规模,以减少不必要的资源消耗。这种弹性计算能力确保了系统在面对大规模计算任务时,能够高效地利用每一份计算资源,降低整体运营成本。

高度定制化与优化

LDAI的去中心化架构还具有极高的定制性。不同的AI应用可能需要不同的硬件配置与计算资源,LDAI允许用户根据自己的需求灵活定制节点的硬件资源及配置。例如,某些任务可能需要高性能的GPU计算,而另一些任务则可能需要大量的存储或数据处理能力。LDAI能够根据这些需求动态分配资源,保证任务高效执行。

此外,LDAI平台还集成了自我优化机制。系统会根据任务执行的历史数据,持续优化调度算法和资源分配策略,从而提高系统的长期运行效率。这种优化过程是自动化的,无需人为干预,大大降低了运维成本,并提升了计算资源的使用效率。

3. Lumoz Decentralized AI 应用场景

LDAI的去中心化架构赋予其多种应用场景,使其在多个领域都具有广泛的应用潜力。以下是几个典型的应用场景:

AI模型训练

AI模型训练通常需要大量的计算资源,而LDAI通过去中心化的计算节点和弹性的资源调度,提供了一个成本效益高且可扩展的平台。在LDAI上,开发者可以将训练任务分发到全球范围内的节点,优化资源利用率,同时大幅降低硬件采购和维护的成本。

微调与推理

除了训练,AI模型的微调和推理也需要高效的计算能力。LDAI的计算资源可以动态调整,以满足微调和推理任务的实时需求。在LDAI平台上,AI模型的推理过程可以更快速地进行,同时保证高精度和稳定性。

分布式数据处理

LDAI的去中心化存储和隐私计算能力使得其在大数据分析中表现尤为出色。传统的大数据处理平台通常依赖于集中式数据中心,这种模式往往面临存储瓶颈和隐私泄露的风险。而LDAI则通过分布式存储和加密计算保证数据的隐私性,同时使得数据处理更加高效。

智能合约与支付

LDAI结合区块链技术,使得开发者可以在平台上进行去中心化支付,例如AI计算任务的费用支付。这种基于智能合约的支付系统,保证了交易的透明性和安全性,并降低了跨境支付的成本与复杂性。

AI应用开发

Lumoz的去中心化架构也为AI应用开发提供了强大的支持。开发者可以在Lumoz的计算平台上创建和部署各种AI应用,从自然语言处理(NLP)到计算机视觉(CV),都可以在LDAI平台上实现无缝运行。

4.总结

Lumoz Decentralized AI 通过创新的去中心化计算架构,结合区块链和零知识证明技术,为全球AI开发者提供了一个安全、透明、去中介化的平台。LDAI打破了传统AI计算的壁垒,使得每个开发者都能公平访问高性能计算资源,并保护用户的数据隐私和安全。

随着LDAI的不断发展,其在AI领域的应用场景将更加丰富,推动全球AI技术的创新与普及。Lumoz的去中心化AI平台将是未来智能社会的基石,帮助全球开发者构建更开放、更公平、更可信的AI生态。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。