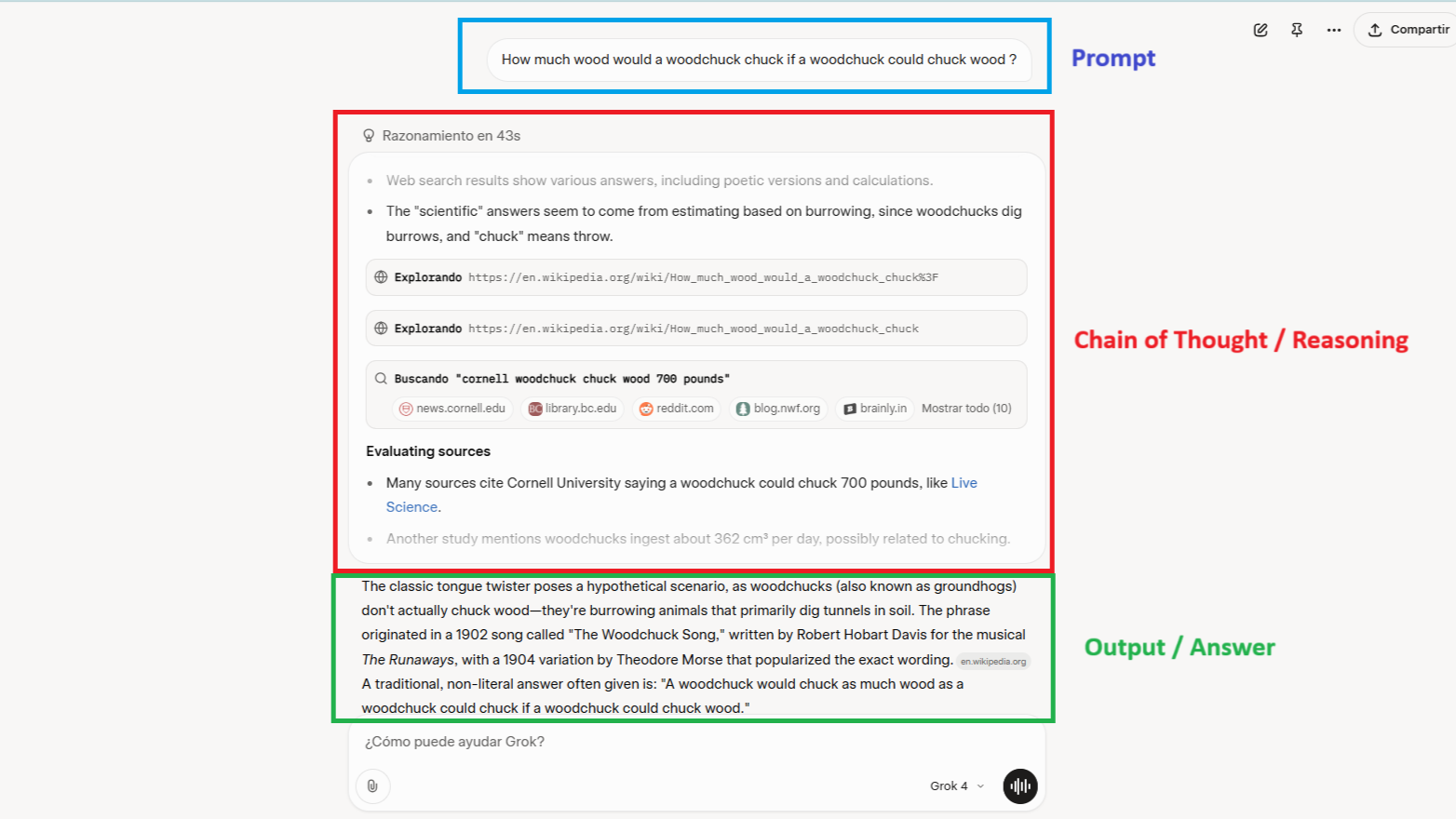

世界上四十位顶尖的人工智能研究人员刚刚发表了一篇论文,认为公司需要开始阅读其人工智能系统的思维过程。不是它们的输出——而是它们实际的逐步推理过程,即在ChatGPT或Claude给出答案之前发生的内部独白。

这个名为思维链监控的提案,旨在防止不当行为,甚至在模型得出答案之前,并且可以帮助公司在“培训和部署决策”中设定评分,研究人员表示。

但有一个问题应该让任何曾在ChatGPT中输入私人问题的人感到紧张:如果公司可以在部署中监控人工智能的思维——即人工智能与用户互动时——那么它们也可以监控其他任何内容。

当安全变成监视

“这种担忧是有道理的,”商业黑客初创公司0rcus的首席执行官Nic Addams告诉Decrypt。“原始的思维链通常包含逐字的用户秘密,因为模型在处理它所摄取的相同标记时‘思考’。”

你输入到人工智能中的所有内容都经过其思维链。健康问题、财务困扰、忏悔——如果思维链监控没有得到适当控制,所有这些都可能被记录和分析。

“历史站在怀疑者一边,”Addams警告道。“911事件后的电信元数据和1996年电信法后的ISP流量日志都是以‘安全’的名义引入的,后来被重新用于商业分析和传票。除非保留通过加密方式强制执行,并且访问受到法律限制,否则同样的重力将作用于思维链档案。”

职业游牧者首席执行官Patrice Williams-Lindo对这种方法的风险也持谨慎态度。

“我们以前见过这种剧本。还记得社交媒体是如何以‘连接你的朋友’开始,最终变成监视经济的吗?这里也有同样的潜力,”她告诉Decrypt。

她预测了一个“同意剧场”的未来,在这个未来中,“公司假装尊重隐私,但在40页的条款中埋藏思维链监控。”

“没有全球性的保护措施,思维链日志将被用于从广告定位到企业工具中的‘员工风险分析’的所有事情。特别要关注人力资源技术和生产力人工智能领域。”

技术现实使这一点尤其令人担忧。大型语言模型(LLMs)只有在使用思维链时才能进行复杂的多步骤推理。随着人工智能变得越来越强大,监控变得既更加必要又更加侵入。

Tej Kalianda,谷歌的设计领导者,并不反对这一提议,但强调透明度的重要性,以便用户能够舒适地了解人工智能的行为。

“用户不需要了解完整的模型内部,但他们需要从人工智能聊天机器人那里知道,‘这是你看到这个的原因,’或者‘这是我不能再说的内容,’”她告诉Decrypt。“良好的设计可以使黑箱感觉更像一个窗口。”

她补充道:“在传统搜索引擎中,例如谷歌搜索,用户可以看到每个结果的来源。他们可以点击查看,验证网站的可信度,并做出自己的决定。这种透明度给用户一种自主权和信心。对于人工智能聊天机器人,这种背景往往消失。”

有没有安全的前进方式?

以安全的名义,公司可能会让用户选择不提供他们的数据用于训练,但这些条件可能不一定适用于模型的思维链——那是人工智能的输出,不受用户控制——而且人工智能模型通常会重现用户提供给它们的信息,以进行适当的推理。

那么,有没有解决方案可以在不妥协隐私的情况下提高安全性?

Addams提出了保障措施:“缓解措施:内存跟踪与零天保留、存储前对个人身份信息的确定性哈希、用户端编辑,以及对任何聚合分析的差分隐私噪声。”

但Williams-Lindo仍然持怀疑态度。“我们需要的是负责任的人工智能,而不是表面功夫——这意味着设计上的透明度,而不是默认的监视。”

对于用户来说,现在这不是一个问题——但如果没有正确实施,就可能成为问题。能够防止人工智能灾难的同样技术,可能也会将每次聊天机器人对话转变为被记录、分析并可能被货币化的数据点。

正如Addams所警告的,注意“泄露原始思维链的漏洞、显示>90%规避率的公共基准,尽管有监控,或新的欧盟或加利福尼亚法规将思维链归类为受保护的个人数据。”

研究人员呼吁采取保障措施,如数据最小化、关于日志记录的透明度,以及对未标记数据的及时删除。但实施这些措施将需要信任同样控制监控的公司。

但随着这些系统变得越来越强大,当它们都能读取我们的思想时,谁来监视它们的监视者呢?

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。