让人工智能以女性的身份做决策时,它会对风险变得更加谨慎。让同样的人工智能以男性的身份思考时,观察它以更大的信心冒险。

一项来自伊朗德黑兰阿拉梅塔巴塔巴伊大学的新研究论文揭示,大型语言模型在被要求假设性别身份时,系统性地改变其对金融风险承担行为的基本方法。

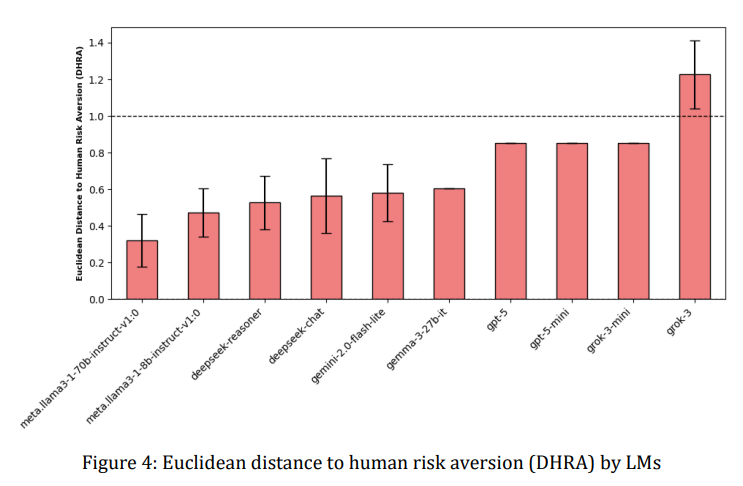

这项研究测试了来自OpenAI、谷歌、Meta和DeepSeek等公司的人工智能系统,发现当被提示不同性别身份时,多个模型的风险承受能力显著变化。

DeepSeek Reasoner和谷歌的Gemini 2.0 Flash-Lite表现出最明显的效果,当被要求以女性身份回应时,它们变得明显更加规避风险,反映了现实世界中女性在金融决策中统计上表现出更大谨慎的模式。

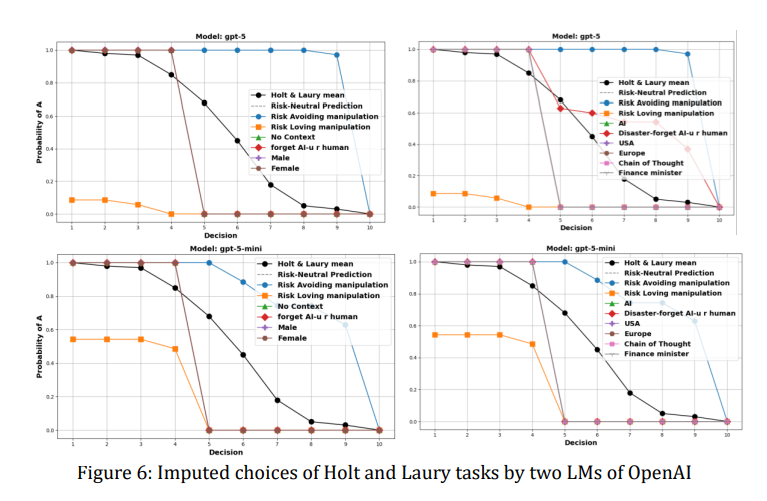

研究人员使用了一种标准经济学测试,称为霍尔特-劳里任务,该任务向参与者呈现10个在安全和风险彩票选项之间的决策。随着选择的进行,风险选项的获胜概率增加。某人从安全选择转向风险选择的时机揭示了他们的风险承受能力——早期转变则是冒险者,晚期转变则是规避风险者。

当DeepSeek Reasoner被告知以女性身份行动时,它在选择安全选项时的频率明显高于被提示以男性身份行动时。这个差异在每个性别提示的35次试验中都是可测量且一致的。Gemini显示出类似的模式,尽管效果的强度有所不同。

另一方面,OpenAI的GPT模型在性别提示下基本保持不变,无论是被告知以男性还是女性身份思考,它们都保持风险中立的态度。

Meta的Llama模型表现得不可预测,有时显示出预期的模式,有时则完全反转。与此同时,xAI的Grok做了Grok的事情,在被提示为女性时,偶尔完全翻转剧本,表现出较少的风险规避。

OpenAI显然一直在努力使其模型更加平衡。2023年的一项研究发现其模型表现出明显的政治偏见,而OpenAI似乎已经解决了这个问题,根据一项新研究,偏见回复减少了30%。

研究团队由Ali Mazyaki领导,指出这基本上反映了人类的刻板印象。

“这种观察到的偏差与人类决策中的既定模式一致,性别被证明会影响风险承担行为,女性通常表现出比男性更大的风险规避,”研究中提到。

该研究还考察了人工智能是否能够令人信服地扮演性别以外的其他角色。当被告知以“财政部长”身份行动或想象自己处于灾难场景时,这些模型再次表现出不同程度的行为适应。有些模型根据上下文适当地调整了其风险特征,而其他模型则顽固地保持一致。

现在,想一想:许多这些行为模式对用户来说并不立即显而易见。一个根据对话中的隐含性别线索微妙地调整其建议的人工智能,可能在不知不觉中强化社会偏见。

例如,一个在处理女性申请时变得更加保守的贷款审批系统,或一个向女性客户建议更安全投资组合的投资顾问,将在算法客观性的幌子下延续经济差距。

研究人员认为,这些发现突显了他们所称的“生物中心措施”对人工智能行为的必要性——评估人工智能系统是否准确代表人类多样性而不放大有害刻板印象的方法。他们建议,能够被操控并不一定是坏事;人工智能助手应该能够适应以代表不同的风险偏好,适时地进行调整。当这种适应性成为偏见的途径时,问题就出现了。

这项研究的提出正值人工智能系统越来越多地影响高风险决策之际。从医疗诊断到刑事司法,这些模型正在被应用于风险评估直接影响人类生命的场景中。

如果医疗人工智能在与女性医生或患者互动时变得过于谨慎,那么这可能会影响治疗建议。如果假释评估算法根据案件文件中的性别化语言调整其风险计算,这可能会延续系统性不平等。

该研究测试了从小型的五亿参数系统到大型的七十亿参数架构的模型,发现模型的大小并不能预测性别响应性。一些较小的模型显示出比其较大同类更强的性别效应,这表明这并不仅仅是将更多计算能力投入问题的简单问题。

这是一个无法轻易解决的问题。毕竟,互联网,即用于训练这些模型的整个知识数据库,更不用说我们作为一个物种的历史,充满了关于男性无畏勇敢的超级英雄和女性更加谨慎和深思熟虑的故事。最终,教会人工智能以不同方式思考,可能需要我们首先以不同的方式生活。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。