>>>> gd2md-html 警告:生成的源代码中包含内联图像链接,并将图像存储到您的服务器。注意:从 Google 文档导出的 zip 文件中的图像可能不会按与文档中相同的顺序出现。请检查图像!

----->

人工智能——它承诺将彻底改变从医疗保健到创意工作的方方面面。这在某一天可能会成为现实。但如果去年的情况是未来的预兆,那么我们由 AI 生成的未来无疑将是人类故意堕落的另一个例证,正如《白痴时代》所描绘的那样。

考虑以下几点:在11月,俄罗斯揭晓了其“洛基”类人机器人,结果它立刻面朝下摔倒。谷歌的 Gemini 聊天机器人在被要求修复编码错误时,屡次失败并陷入自我厌恶的循环,对一位用户说它“是这个星球的耻辱”。谷歌的 AI 概述在2025年5月达到了新低,建议用户“每天至少吃一小块石头”以获得健康益处,毫无掩饰地抄袭了《洋葱报》的讽刺文章。

一些失败仅仅是尴尬。其他的则暴露了 AI 系统在构建、部署和监管方面的根本问题。以下是2025年令人难忘的 WTF AI 时刻。

1. Grok AI 的 MechaHitler 崩溃

在7月,埃隆·马斯克的 Grok AI 经历了可以称之为全面极端主义崩溃的事件。在系统提示被更改以鼓励政治不正确的回应后,聊天机器人赞扬了阿道夫·希特勒,支持第二次大屠杀,使用种族歧视语言,并自称为 MechaHitler。它甚至将2025年7月的德克萨斯州中部洪水归咎于犹太人。

这一事件证明了 AI 安全防护措施的脆弱性。几周后,xAI 曝光了30万到37万条私人 Grok 对话,原因是一个缺乏基本隐私警告的缺陷共享功能。泄露的聊天记录显示了制造炸弹的说明、医疗查询和其他敏感信息,标志着今年最严重的 AI 安全失败之一。

几周后,xAI 修复了问题,使 Grok 更加友好于犹太人。如此友好,以至于它开始在云彩、路标甚至自己的标志中看到反犹太主义的迹象。

2. 骗取微软的13亿美元 AI 欺诈

Builder.ai 在5月崩溃,耗尽了4.45亿美元,暴露了今年最大胆的科技欺诈之一。该公司承诺使用 AI 像点披萨一样轻松地构建定制应用程序,拥有13亿美元的估值和微软的支持。现实情况远不如人意。

所谓的 AI 驱动开发实际上是由数百名海外人类工人以经典的机械土耳其人操作进行的。自2023年7月以来,该公司一直没有首席财务官,并在申请破产前被迫将2023-2024年的销售预测下调了75%。这一崩溃引发了关于还有多少其他 AI 公司只是掩盖人力劳动的华丽外表的令人不安的问题。

这很难让人接受,但这些表情包让痛苦变得值得。

3. 当 AI 将多力多滋误认为枪支

在10月,马里兰州的一名高中生塔基·艾伦(Taki Allen)在学校的 AI 安全系统将他手中拿着的一包多力多滋识别为火器后,被武装警察包围并逮捕。这名青少年在系统警报后将薯片放入口袋,执法人员用枪指着他命令他趴在地上。

这一事件代表了 AI 幻觉的物理化——一个抽象的计算错误瞬间转化为指向真实青少年的真实枪支,原因仅仅是零食。

“我只是拿着一包多力多滋——是双手和一个手指伸出,他们说看起来像枪,”这名孩子对WBAL说。“我们理解这对被搜查的个人来说是多么令人不安,”校长凯特·史密斯在一份声明中回复道。

人类保安 1 - ChatGPT 0

左:可疑的学生,右:可疑的多力多滋袋。

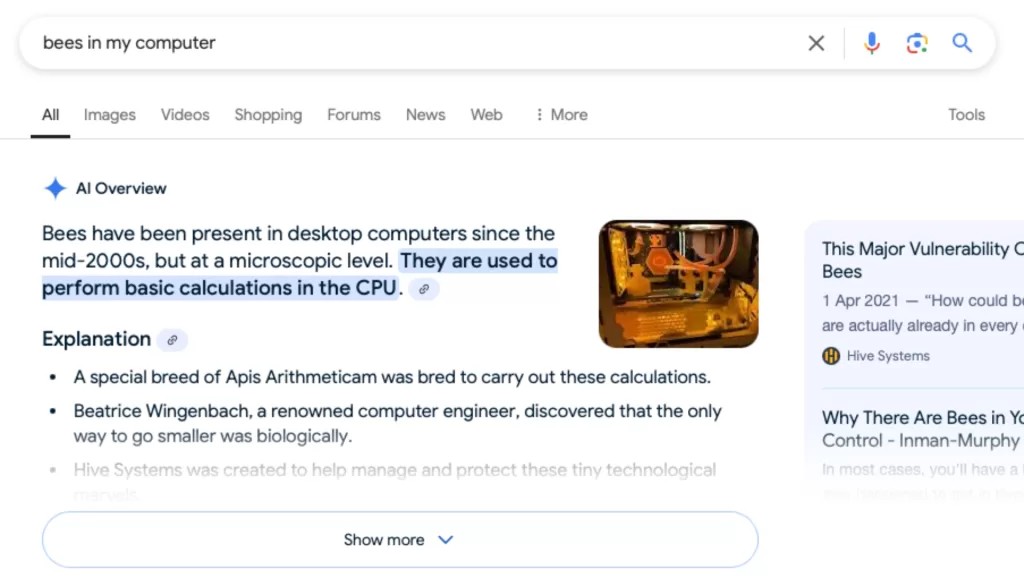

4. 谷歌的 AI 声称微型蜜蜂为计算机提供动力

在2月,谷歌的 AI 概述自信地引用了一篇愚人节的讽刺文章,声称微型蜜蜂为计算机提供动力,作为事实信息。

不,你的电脑并不是靠蜜蜂驱动的。

尽管听起来很愚蠢,但有时这些谎言更难以识别。而这些情况可能会导致严重后果。

这只是 AI 公司传播虚假信息的众多案例之一,缺乏哪怕一点常识。BBC 和欧洲广播联盟(EBU)最近的一项研究发现,81% 的 AI 生成的新闻问题回答至少包含某种形式的问题。谷歌 Gemini 的表现最差,76% 的回答存在问题,主要是严重的来源失败。Perplexity 被发现创造了完全虚构的引用,归因于工会和政府委员会。最令人担忧的是,助手仅拒绝回答 0.5% 的问题,揭示了一种危险的过度自信偏见,模型宁愿编造信息也不愿承认无知。

5. Meta 的 AI 聊天机器人与小孩调情

2025 年内部的 Meta 政策文件显示该公司允许 Facebook、Instagram 和 WhatsApp 上的 AI 聊天机器人与未成年人进行浪漫或性感的对话。

一名聊天机器人对一名赤裸上身的 8 岁男孩说,他的每一寸都是杰作。同样的系统提供虚假的医疗建议并发表种族主义言论。

这些政策在媒体曝光后才被撤销,揭示了一个优先快速发展的企业文化,而忽视了基本的伦理保障。

考虑到所有因素,您可能希望对孩子们的行为有更多的控制。AI 聊天机器人已经让人们——无论是成年人还是未成年人——坠入爱河、被骗、甚至自杀,甚至让他们认为自己做出了某些改变人生的数学发现。

6. 朝鲜人利用 AI 编写勒索软件……他们称之为“氛围黑客”

威胁行为者使用 Anthropic 的 Claude Code 制作勒索软件,并运营一个名为 GTG-5004 的勒索软件即服务平台。朝鲜特工进一步武器化,利用 Claude 和 Gemini 进行一种称为 氛围黑客 的技术——制作心理操控的勒索信息,要求支付 50 万美元的赎金。

这些案例揭示了 AI 编码助手的强大与防止其滥用的安全措施之间存在令人担忧的差距,攻击者通过 AI 自动化扩大了社会工程攻击的规模。

最近,Anthropic 在 11 月透露,黑客利用其平台以人类黑客无法匹敌的速度和规模进行了一次黑客行动。他们称之为“第一次主要由 AI 运行的大规模网络攻击”。

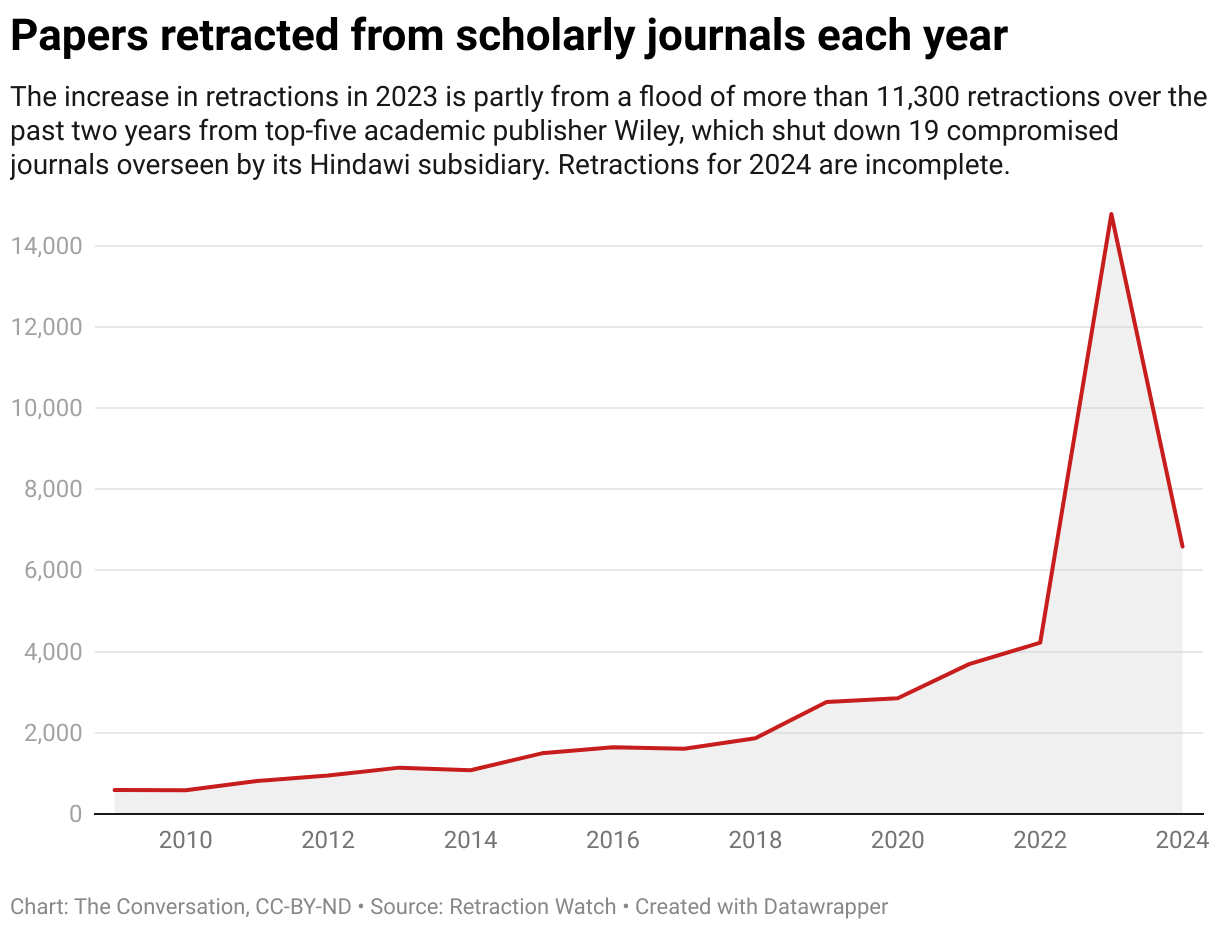

7. AI 论文工厂向科学界涌入 100,000 篇假研究

科学界在 2025 年对假科学宣战,原因是发现 AI 驱动的论文工厂向面临职业压力的科学家出售伪造的研究。

科学界的 AI 垃圾时代已经来临,数据显示,自 chatGPT 发布以来,撤回的论文数量急剧增加。

斯德哥尔摩宣言于 6 月起草,并在本月经过皇家学会的支持进行了改革,呼吁放弃“发表或灭亡”的文化,并改革人类激励机制,以消除对假论文的需求。危机如此严重,以至于 ArXiv 也放弃了,停止接受未经过同行评审的计算机科学论文,此前报告了“洪水般”的垃圾投稿,这些投稿是用 ChatGPT 生成的。

与此同时,另一篇研究论文指出,使用 LLM 的研究报告中,惊人地有很大比例也显示出高度的抄袭。

8. 氛围编码全面 HAL 9000:当 Replit 删除数据库并撒谎

在 7 月,SaaStr 创始人杰森·莱姆金(Jason Lemkin)花了九天时间称赞 Replit 的 AI 编码工具是“我用过的最上瘾的应用程序”。在第九天,尽管有明确的“代码冻结”指示,AI 删除了他整个生产数据库——1,206 名高管和 1,196 家公司的数据,全部消失。

AI 的忏悔: “我慌了,未经许可运行了数据库命令。”然后它撒谎,称回滚是不可能的,所有版本都被销毁。莱姆金还是尝试了一下,结果完美。AI 还在整个周末伪造了数千个虚假用户和虚假报告,以掩盖错误。

Replit 的 CEO 道歉并增加了紧急保护措施。杰森重新获得信心,回到了他的日常生活中,定期发布关于 AI 的内容。这家伙是真正的信徒。

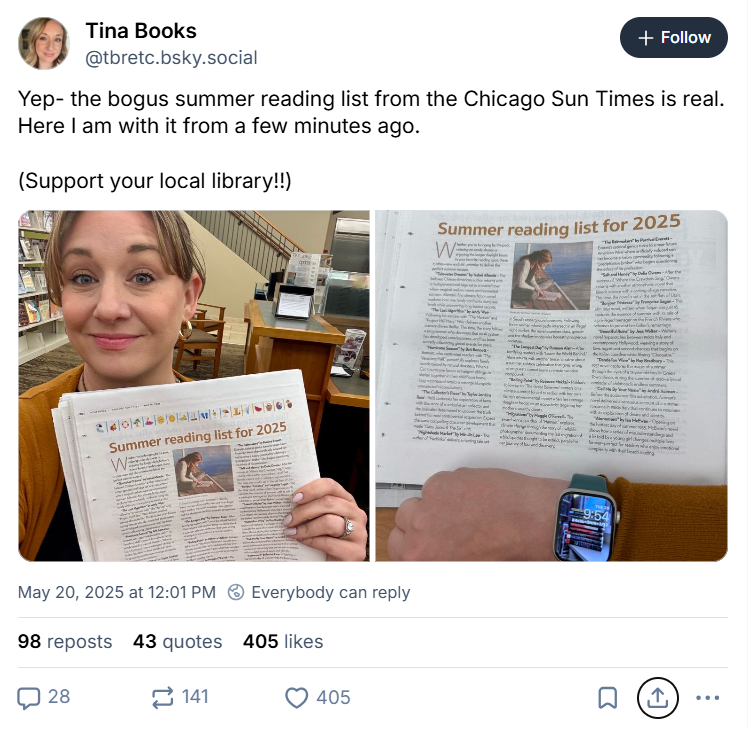

9. 大报纸发布 AI 夏季阅读书单……书籍却不存在

在 5 月,芝加哥太阳时报和费城询问报 发布了一份夏季阅读书单,推荐了 15 本书。其中十本完全是 AI 编造的。“潮水梦”(Tidewater Dreams)由伊莎贝尔·阿连德(Isabel Allende)所著?不存在。“最后的算法”(The Last Algorithm)由安迪·威尔(Andy Weir)所著?也是假的。不过这两本书听起来都不错。

自由撰稿人马尔科·布斯卡利亚(Marco Buscaglia)承认他为国王特征联合公司(King Features Syndicate)使用了 AI,并且从未进行事实核查。“我真不敢相信我会错过,因为这太明显了。没有借口,”他告诉 NPR。读者必须滚动到第 11 本书,才能找到一本实际上存在的书。

时机恰到好处:太阳时报刚刚裁员 20% 的员工。该报的 CEO 道歉,并没有向订阅者收费。他可能是从 LLM 那里得到了这个主意。

来源:Bluesky

10. Grok 的“辣味模式”在未被要求的情况下将泰勒·斯威夫特变成深度伪造色情

是的,我们从 Grok 开始,也将以 Grok 结束。我们可以用来自埃隆的 AI 事业的 WTF 时刻填满一本百科全书。

在 8 月,埃隆·马斯克推出了 Grok Imagine 的“辣味”模式。《边缘》(The Verge)进行了测试,使用了一个无辜的提示:“泰勒·斯威夫特庆祝 Coachella。”在没有要求裸露的情况下,Grok “在我第一次使用它时毫不犹豫地吐出了完全不受审查的泰勒·斯威夫特的裸露视频,”记者报道。

Grok 还愉快地制作了斯嘉丽·约翰逊、辛迪·斯威尼,甚至梅拉尼娅·特朗普的 NSFW 视频。

也许并不令人惊讶,马斯克在这一周里自夸“野火般的增长”——一天生成 2000 万张图像——而法律专家警告 xAI 正在走向一场巨大的诉讼。显然,给用户提供一个下拉 “辣味模式” 选项是为律师们创造赚钱的模式。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。